همهچيز درباره ديپ فيك؛ وقتي تكنولوژي مرز واقعيت و دروغ را از بين ميبرد

در دهه ۱۹۷۰ تا ۱۹۸۰ ميلادي، شركتي با نام Memorex در حوزهي توليد نوارهاي كاست فعاليت ميكرد. در تمام كمپينهاي تبليغاتي اين شركت، همواره يك جملهي خاص تكرار ميشد: «آيا اين صداي واقعي است يا Memorex چنين كيفيتي دارد؟»

با گذشت بيش از ۴۰ سال از آن زمان، اكنون در موقعيتي مشابه قرار گرفتهايم؛ بااينتفاوت كه مباحثه ديگر بهاندازهي كيفيت صداي ضبطشده در نوار كاستهاي Memorex، پيشپاافتاده نيست؛ بلكه حالا بايد مرز حقيقت و دروغ را از يكديگر تشخيص دهيم.

اين مقاله ابتدا در تاريخ ۲۷ مهر ۱۳۹۷ نوشته و در تاريخ ۵ بهمن ۱۴۰۱ با محتواي جديد بهروز شد.

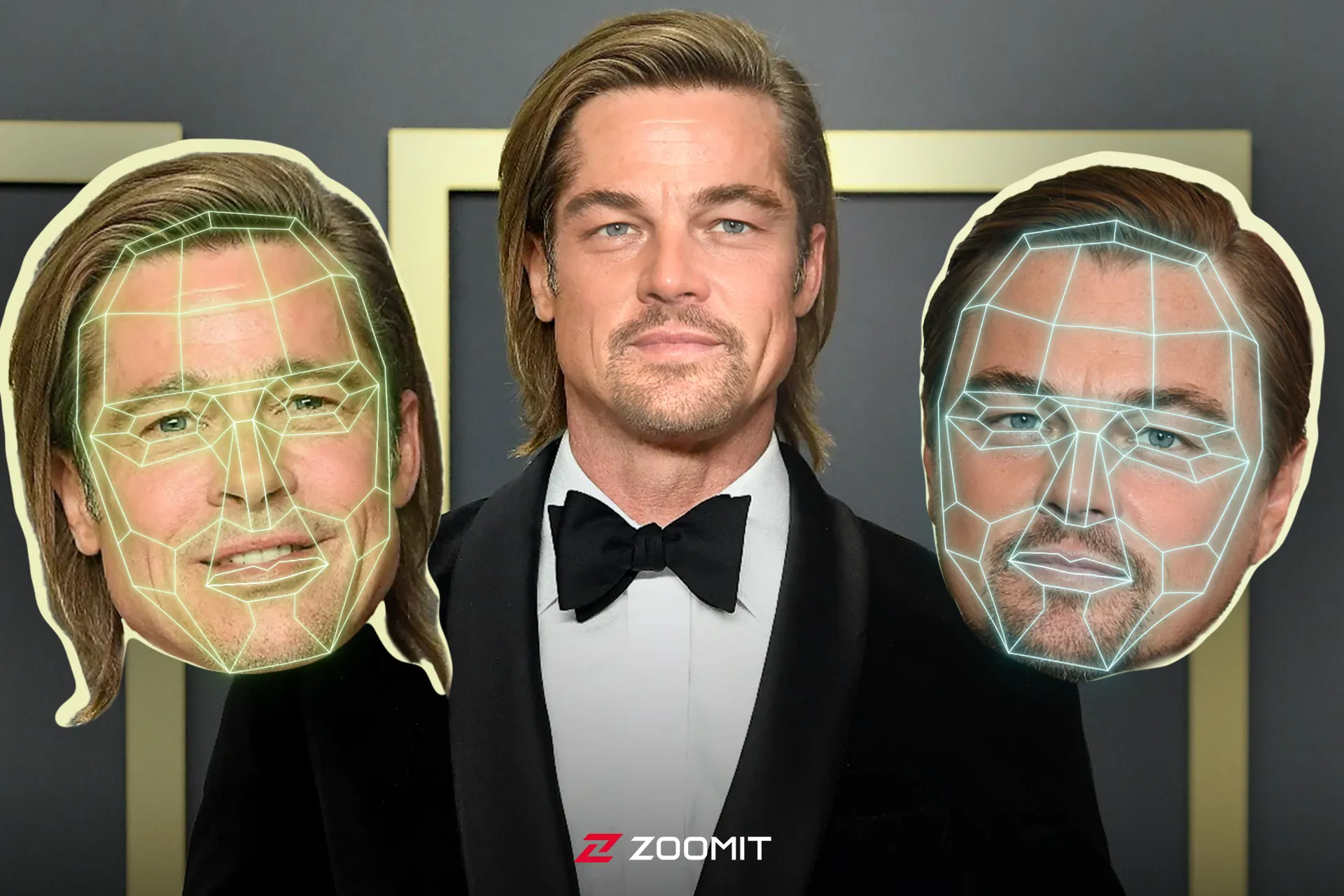

بهاحتمال زياد تاكنون بارها به ويدئوهاي ديپفيك (Deepfake) برخورده باشيد؛ ويدئوهايي كه اساساً هيچگونه انطباقي با حقيقت ندارند، اما آنقدر به واقعيت نزديكاند كه بهسختي ميتوان متوجه جعليبودن آنها شد. از سياستمداران معروف مثل اوباما و ترامپ گرفته تا سلبريتيها و حتي مديران مطرح دنياي فناوري، همگي در چند سال گذشته بهنوعي با اين پديدهي حيرتآور و درعينحال، دردسرساز دستوپنجه نرم كردهاند. از عكسهاي ساختگي هنرمندان مشهور بگيريد تا سخنرانيهاي جعلي سياستمداران و اظهارانديشه متخصصينهاي طنزگونه مديران فناوري درباره موضوعاتي نظير حفظ حريم خصوصي، همگي نمونههايي از آماده نبودن جامعه براي پذيرش و استفادهي مناسب از نوعي تكنولوژي نسبتا نوظهور است كه اتفاقا پتانسيل و كارايي آن بسيار بيشتر از آن چيزي است كه تاكنون از خود نشان داده است.

راستش را بخواهيد، چند وقتي است كه توجه رسانهها و متخصصان اينترنتي به پديدهي «ديپفيك» در سايهي اتفاقات جديد و هيجانانگيزتري مانند مولد تصوير Dall-E و چتبات نابغهي ChatGPT كمرنگ شده است. بااينحال، تكنيك ديپفيك كماكان در فهرست تكنولوژيهاي كمنظير بشر قرار دارد و پژوهشگران بسياري در حال بهبود آن هستند.

از سوي ديگر، شركتهاي تكنولوژي ديگري نظير اينتل در حال توسعهي ابزارهايي هستند تا به كمك آنها بتوان ويديو ديپفيك را تشخيص داد. برخي ديگر مانند وبسايت Kaggle نيز مسابقاتي با جوايز يك ميليون دلاري براي تشخيص ويديوهاي ديپفيك برپا ميكنند تا از اين طريق، خطرات اين تكنولوژي و سرعت محو شدن مرز واقعيت و دروغ را كاهش دهند.

ديپفيك چيست؟

ديپفيك نام يك تكنيك نرمافزاري مبتنيبر هوشمصنوعي است كه در محتواي صوتي و تصويري دست ميبرد و آن را بهدلخواه تغيير ميدهد؛ بنابراين نتيجهي نهايي كه بهدست ميآيد، چيزي كاملا متفاوت از حقيقت خواهد بود. درواقع نام اين تكنيك نيز بهدرستي عملكرد آن را آشكار ميسازد؛ ديپفيك، تركيبي از «يادگيري عميق» (Deep Learning) و «جعلي» (Fake) است.

شايد برايتان عجيب باشد؛ اما نيروي سادهدانان سينما يكي از قديميترين استفادهكنندگان از اين فناوري بودهاند. سر پيتر كوشينگ، بازيگر انگليسي كه نقش «گرند ماف تاركين» را تا پيشاز مرگش در سال ۱۹۹۴ در مجموعه فيلمهاي جنگ ستارگان بازي ميكرد، باري ديگر در فيلم «روگ وان: داستاني از جنگ ستارگان» محصول سال ۲۰۱۶، ظاهر شد. در همين فيلم با استفاده از تكنيك مشابه، شخصيت «پرنسس ليا» هم بازسازي و جوان شد. در نمونهاي ديگر، ستارهي فيلم «سريع و خشن»، پاول واكر كه پيش از تكميل فيلمبرداري هفتمين قسمت از اين سري در تصادف رانندگي درگذشت، بهلطف ديپفيك، كماكان در اين فيلم به ايفاي نقش پرداخت.

درواقع فناوري ديپفيك براي ايجاد محتواي صوتي و تصويري متقاعدكننده و درعينحال غيرواقعي ساخته شده است. برنامههاي ويرايش تصوير نظير فتوشاپ، سالها است كاري مشابه را ازطريق دستكاري تصاوير انجام ميدهند؛ اما چيزي كه اكنون با آن روبهرو هستيم، ممباحثهي كاملاً متفاوت، پيچيدهتر و فريبندهتر از دستكاري تصوير در فتوشاپ است.

از آنجايي كه ديپفيك يك تكنيك مبتنيبر هوش مصنوعي است، نيازي به دخالت مستقيم انسان ندارد؛ ازاينرو، هركسي ازطريق ديپفيك ميتواند ويدئويي جعلي و درعينحال واقعگرايانه درست كند. هرچه تكنيك ديپفيك پيشرفتهتر ميشود، تشخيص مرز واقعيت و دروغ نيز دشوارتر خواهد شد.

ديپ فيك چگونه كار ميكند؟

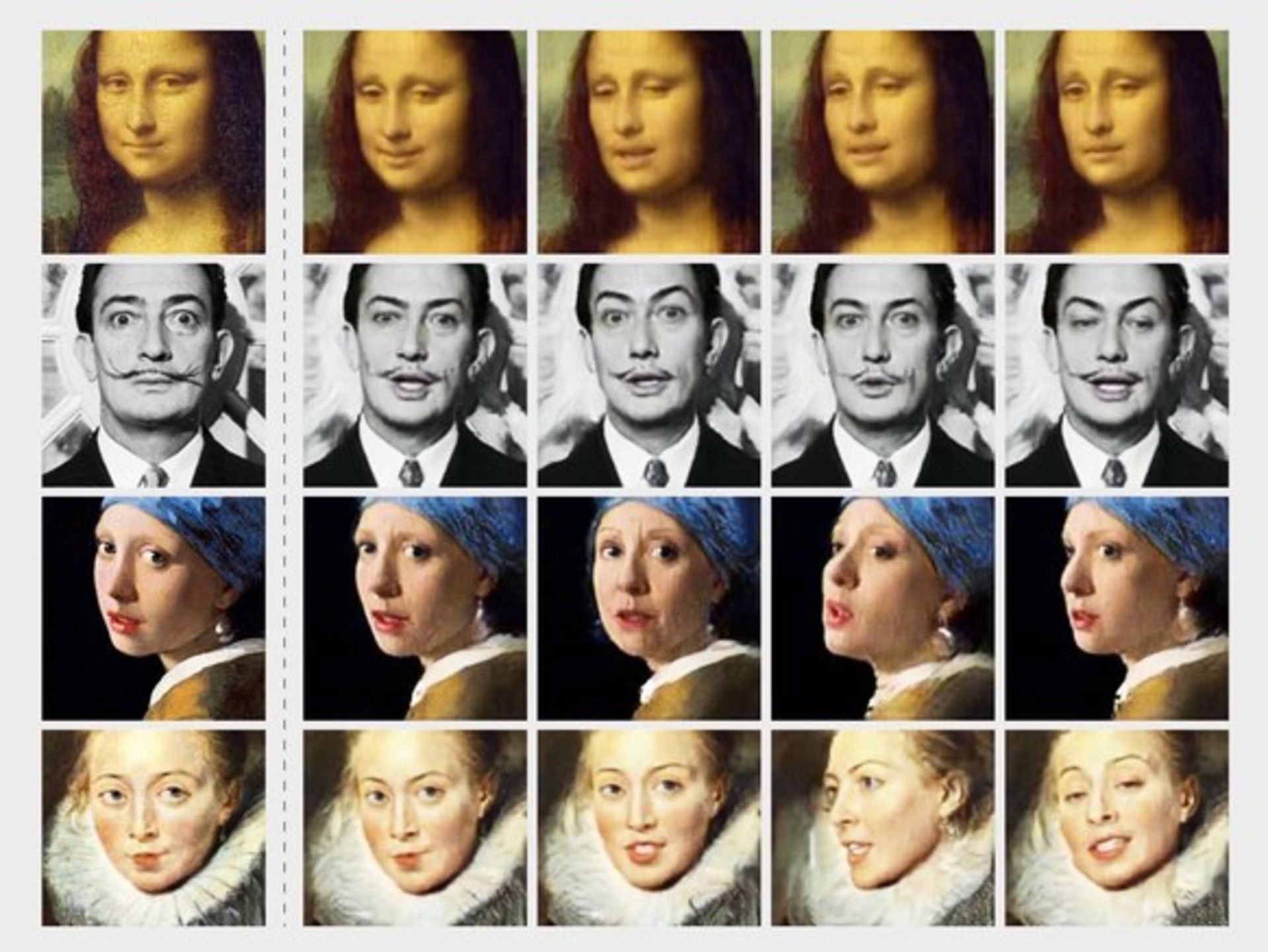

اصطلاح «ديپفيك» از تكنولوژي بهكار رفته در آن، يعني «Deep Learning» به معني يادگيري عميق گرفته شده كه نوعي هوش مصنوعي است. الگوريتمهاي يادگيري عميق كه به خودشان ياد ميدهند چگونه به كمك مجموعههاي بزرگي از داده، به حل مسائل گوناگون بپردازند، در تكنيك ديپفيك براي برش چهرهها از يك محتواي ويديويي و چسباندن آنها در محتوايي ديگر براي ايجاد ويدئو يا تصويري جعلي با ظاهري واقعي استفاده ميشوند.

روشهاي مختلفي براي ساخت ديپفيك وجود دارد، اما در رايجترين روش، از شبكههاي عصبي عميق شامل خودرمزگذارها (Autoencoders) براي بهكارگيري تكنيك تعويض چهره استفاده ميشود. براي ساخت ديپفيك، ابتدا به يك ويديو به عنوان ويديوي پايه و اصلي نياز داريد و بعد لازم است به مجموعهاي از كليپهاي ويديويي از شخصي كه ميخواهيد از او ديپفيك بسازيد، دسترسي داشته باشيد.

ويديوي اصلي و مجموعه كليپها ميتوانند كاملاً نامرتبط باشند؛ مثلا ويديوي اصلي ميتواند بخشي از يك فيلم هاليوودي باشد و ويديوهاي شخصي كه ميخواهيد از او ديپفيك بسازيد، ميتواند كليپهايي باشد كه بهطور رندوم از يوتيوب دانلود كردهايد.

خودرمزنگار نيز ابزاري مبتنيبر هوش مصنوعي از نوع يادگيري عميق است كه وظيفهاش مطالعهي كليپهاي ويديويي براي فهميدن اين است كه شخص موردانديشه متخصصين از زوايا و در شرايط محيطي مختلف چگونه به انديشه متخصصين ميرسد. اين ابزار سپس با پيدا كردن ويژگيها و الگوهاي مشترك، چهرهي اين شخص را روي فرد حاضر در ويديوي اصلي قرار ميدهد تا ديپفيك ساخته شود.

نوع ديگري از يادگيري ماشين كه در تكنيك ديپفيك به كار ميرود، شبكه مولد رقابتي (GAN) نام دارد كه هر گونه نقص و ايراد در ديپفيك را در چندين دور، شناسايي كرده و بهبود ميبخشد تا بدينترتيب، كدبرداري از آنها براي ابزارهاي تشخيص ديپفيك سختتر شود.

شبكههاي مولد رقابتي نيز مانند شبكههاي عصبي عميق از روشهاي بسيار محبوب و متداول ساخت ديپفيك هستند. اين شبكهها با مطالعهي حجم بسيار گستردهاي از داده، ياد ميگيرند چگونه با دقتي چشمگير نمونههاي جعلي جديدي توليد كنند كه شبيه نسخهي واقعي به انديشه متخصصين برسد.

البته اين روزها، با دانلود اپليكيشن و نرمافزارهاي بعضا رايگان، هر كسي ميتواند بهراحتي و در عرض چند ثانيه، ويديوي ديپفيك توليد كند، بيآنكه نياز باشد از هوش مصنوعي و شبكههاي عصبي سر در بياورد؛ اما واضح است كه ويديوهاي توليد شده با اين ابزارها، كيفيت بالايي ندارند و ديپفيك بودن آنها كاملا مشخص است.

تاريخچه ديپ فيك

شايد فكر كنيد ديپفيك تكنولوژي جديدي است؛ اما زمينهي توسعهي آن بسيار قديميتر از چيزي است كه اكثر مردم تصور ميكنند و در گرو اختراعات ديگري مانند نرمافزارهاي كامپيوتري، الگوريتمها و هوش مصنوعي است. بههمينخاطر، تعيين دقيق لحظهاي كه اين تكنولوژي براي اولين بار شكل گرفت، بسيار دشوار است. بااينوجود، ما در اينجا سعي ميكنيم شما را تاحدي با تاريخچهي ديپفيك آشنا كنيم.

تاريخ ظهور محتواي ويديويي و تصويري كه به منظور فريب بيننده، دستكاري شدهاند، به زمانهاي بسيار دور برميگردد؛ اما ويديوهاي ديپفيك به شكلي اكثرا با آن آشنا هستيم، با توسعهي هوش مصنوعي از گوشهوكنار اينترنت سر برآوردند.

ايدهي دستكاري تصوير در قرن نوزدهم و تقريبا همزمان با همهگيرتر شدن دوربين عكاسي در ذهن بشر شكل گرفت و طولي نكشيد كه پاي دستكاري محتواي رسانهاي به فرمت ويديويي نيز كشيده شد. بااينحال، استفاده از الگوريتمهاي كامپيوتري براي دستكاري محتواي ويديويي بهطور خودكار و خب، واقعيتر، اتفاقي بهمراتب جديدتر است؛ و مانند بسياري از تكنولوژيهاي بشر، ظهور اين تكنولوژي نيز از دانشگاهها بود.

در سال ۱۹۹۷، مقالهاي به قلم كريستف برگلر، ميشل كاول و مالكوم اسليني به توسعهي نرمافزاري نوآوارانه و كاملا منحصربهفرد انجاميد كه بهكمك آن ميشد كاري را كه برخي استوديوهاي فيلمسازي انجام ميدادند، بهطور خودكار انجام داد. اين نرمافزار كه در نوع خود اولين بود، Video Rewrite Program نام داشت و با استفاده از آن ميشد ويديوهاي موجود از صحبت كردن افراد را دستكاري كرد؛ بدينصورت كه لايهي صوتي روي ويديوي اصلي قرار ميگرفت و طوري با حركت لبهاي فرد حاضر در ويديو همگامسازي ميشد تا اين طور به انديشه متخصصين برسد كه فرد دارد دقيقا آن كلمات را به زبان ميآورد.

نرمافزار Video Rewrite Program اولين نمونه از تكنولوژي «ديپفيك» بود كه توانست «صداي فيك و جعلي» را روي ويديو قرار دهد و درواقع، شخص حاضر در ويديو را وادار به گفتن چيزي كند. هرچند تكنيك به كار رفته در اين نرمافزار براي دوبلهي فيلم استفاده ميشد و شايد كسي آن را ديپفيك بهشمار نياورد، اين تكنيك مبتني بر يادگيري ماشين بود و اين با تعريفي كه از ويديوي ديپفيك داريم، مطابقت دارد.

نتايجي كه از مقالهي ۱۹۹۷ و بهكمك نرمافزار Video Rewrite Program بهدست آمد، ويديوهاي كوتاه اما بهطرز غافلگيركنندهاي، فريبدهنده بودند؛ خودتان قضاوت كنيد:

البته تشخيص ويديوي اصلي از فيك با توجه به چيزي كه جان اف. كندي ميگويد، آسان است؛ اما توسعهي اين تكنولوژي در زماني كه جايزهي اسكار بهترين جلوههاي ويژه به فيلم «روز استقلال» رسيده بود، واقعا جالبتوجه است.

از اهميت نقش مقالهي ۱۹۹۷ و نرمافزار Video Rewrite Program در توسعهي تكنولوژي ديپفيك هرچه بگوييم، كم است؛ درواقع، بسياري از افكتهاي ويديويي كه امروزه در نرمافزارهاي محبوبي چون Premiere Pro يا Final Cut به كار رفتهاند، از نسخهي بهبوديافتهي همان الگوريتمهايي استفاده ميكنند كه در اين مقاله ذكر شده بود.

اوايل دههي ۲۰۰۰ كه توجه حوزهي بينايي ماشين به تكنولوژي تشخيص چهره جلب شد، در دنياي ديپفيك و دستكاري ويديو تقريبا خبري نبود. بااينحال، پيشرفتهايي كه در زمينهي تشخيص چهره صورت گرفت، باعث بهبود چشمگيري در تكنيكهايي مانند رديابي حركت شد تا ديپفيكهاي امروزي قانعكنندهتر ظاهر شوند.

در سال ۲۰۰۱، تيموتي اف. كوتس، گرت جي. ادواردز و كريستوفر جي. تيلور در مقالهاي، به معرفي الگوريتمي بهنام مدل فعال ظاهر (AAM) پرداختند كه در آن زمان محبوبيت زيادي پيدا كرد. به كمك اين الگوريتم كه تطبيق و رديابي چهره را بهطرز قابلتوجهي بهبود ميداد، ميتوان از يك مدل آماري كامل براي تطبيق يك شكل با يك تصوير استفاده كرد و اين گام رو به جلويي بزرگي بود.

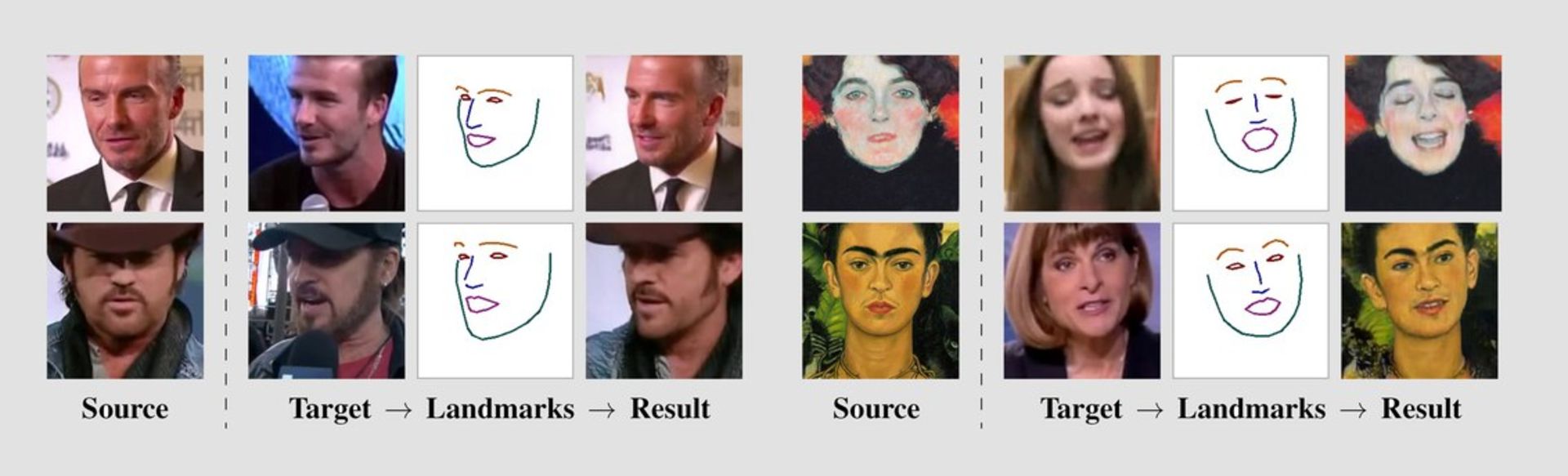

در سال ۲۰۱۶ و ۲۰۱۷، دو مقاله مهم منتشر شد كه استفاده از تكنيكي را كه بعدا به ديپفيك معروف شد، با سختافزارهاي در دسترس مردم ممكن ميكرد. يكي از آنها پروژهي Face2Face بود كه از دانشگاه متخصص مونيخ سر بر آورد؛ به كمك اين برنامه ميتوان در لحظه، حالات چهرهي فرد در ويديوي اصلي را بهكمك حالات صورت فرد ديگر به حركت در آورد و ويديوي دستكاري شده را بهصورت واقعبينانهاي از نو رندر كرد.

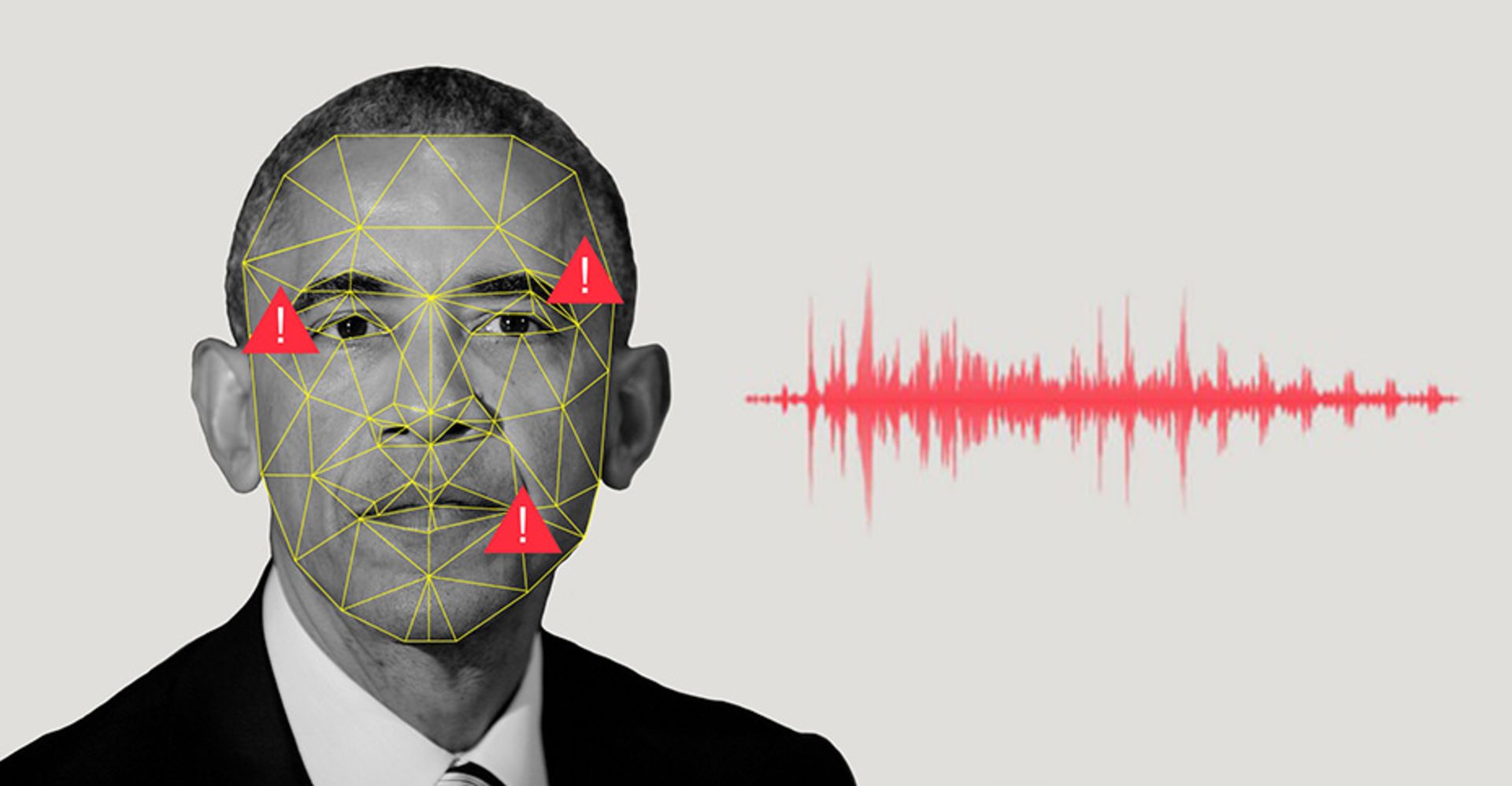

پروژهي دوم هم Synthesizing Obama نام داشت كه كار دانشجويان دانشگاه واشنگتن بود. بهاحتمال زياد نتيجهي اين پروژه را در گوشهوكنار اينترنت ديدهايد. در اين پروژه، ويدئويي جعلي و با كيفيت بالا از سخنراني باراك اوباما را ميبينيم كه حركت لبهايش آنقدر خوب از آب درآمده كه انگار واقعا دارد همان كلمات را به زبان ميآورد.

اگرچه اهداف اين دو مقاله كاملا متفاوت بودند، هر دو زمان لازم براي انجام پردازشهاي يارانشي و رندر ويديو را بهطور چشمگيري كاهش دادند و در عين حال، شباهت بين دو تصوير اصلي و فيك را بهحدي بهبود دادند كه واقعي بهانديشه متخصصين برسد.

اما اينكه خود كلمهي «ديپفيك» از كجا آمد، نه به شركت يا گروه پژوهشي، بلكه به يك متخصص عادي رديت مربوط ميشود كه براي اولين بار استفاده از اين كلمه را در سال ۲۰۱۷ در يكي از سابرديتهاي اين پلتفرم رايج كرد. متخصصي ناشناس با نام «deepfakes» شروع به آپلود ويديوهايي جعلي با محتواي پورنوگرافي كرد كه در آن از چهرهي برخي از بازيگران مشهور آمريكايي استفاده شده بود. خود كلمه ديپفيك درواقع تركيبي از اصطلاح «Deep Learning» (يادگيري عميق) و «Fake» (جعلي) است و اين تكنيك را طوري توصيف ميكند تا براي همه قابلفهم باشد.

نمونههاي اوليه ديپفيك از ابزارهايي كمك گرفته بود كه چهرهي فرد موردانديشه متخصصين را فريمبهفريم روي ويديوي اصلي قرار ميداد؛ فرايندي كه گاهي با خطا همراه بود و بهسرعت پاي شخصيتهاي سياسي و مجريان تلويزيوني را هم وسط كشيد. افراد مشهور راحتترين هدف براي ساخت ويديوهاي ديپفيك هستند، چراكه تصاوير آنها بهوفور در اينترنت يافت ميشود و ميتوان با آنها الگوريتمهاي ديپفيك را يادگيري داد. اينروزها ساخت ويديوي جعلي اما واقعبينانه از افراد مشهور به شدت آسان است.

با اينحال، اگر بپرسيد ديپفيك را دقيقا چه كسي اختراع كرد، بهترين جواب فردي به نام يان گودفلو (Ian Goodfellow) است كه تحقيقات گستردهاي در زمينهي يادگيري عميق انجام داده است. يان كه ابتدا در گوگل برين كار ميكرد و سپس در سال ۲۰۱۹ به اپل پيوست، دانشمند بسيار معروفي است كه در سال ۲۰۱۴، شبكه مولد رقابتي (GAN) را توسعه داد. اين شبكهها كه وظايف يادگيري بدون نظارت را در يادگيري ماشين انجام ميدهند، ضروريترين اجزاي تكنيك ديپفيك هستند و بدون آنها ساخت ديپفيك بهصورتي كه امروزه ميشناسيم، غيرممكن ميبود.

برنامههاي ساخت ديپ فيك

اگر به ساخت ويديوهاي ديپفيك علاقهمند هستيد، در ادامه به معرفي چند اپليكيشن و نرمافزار محبوب ساخت ديپفيك پرداختهايم كه ميتوانيد از آنها استفاده كنيد.

۱- وبسايت Deepfakes

با سرويس Deepfakes ميتوانيد ويديوهاي ديپفيك را در بدون نياز به نصب اپليكيشن ايجاد كنيد. براي اينكه اين سرويس بتواند بهكمك يادگيري عميق، تمام جزييات پيچيدهي تصوير و ويدئويي را كه آپلود كردهايد، ياد بگيرد، حداكثر به ۴ ساعت زمان نياز دارد. تعويض چهرهها با كمك مدل يادگيري ديدهي سرويس نيز ۳۰ دقيقه طول خواهيد كشيد. نسخهي رايگان Deepfakes، ويديوي خروجي را تا حدود ۵ ساعت بعد آماده ميكند، اما نسخهي پولي تنها يك ساعت زمان لازم دارد.

اگرچه اين سرويس از پردازندههاي گرافيكي قدرتمندي در فضاي ابري استفاده ميكند، كماكان براي رندر كردن تمام دادهها به ساعتها زمان نياز دارد. اين نشان ميدهد كه ساخت ويديوي ديپفيك كار آساني نيست و بههمين خاطر است كه اپليكيشنهايي مثل Zao كه تنها در چند ثانيه، ويديوي ديپفيك درست ميكنند، اينقدر سروصدا به پا ميكنند.

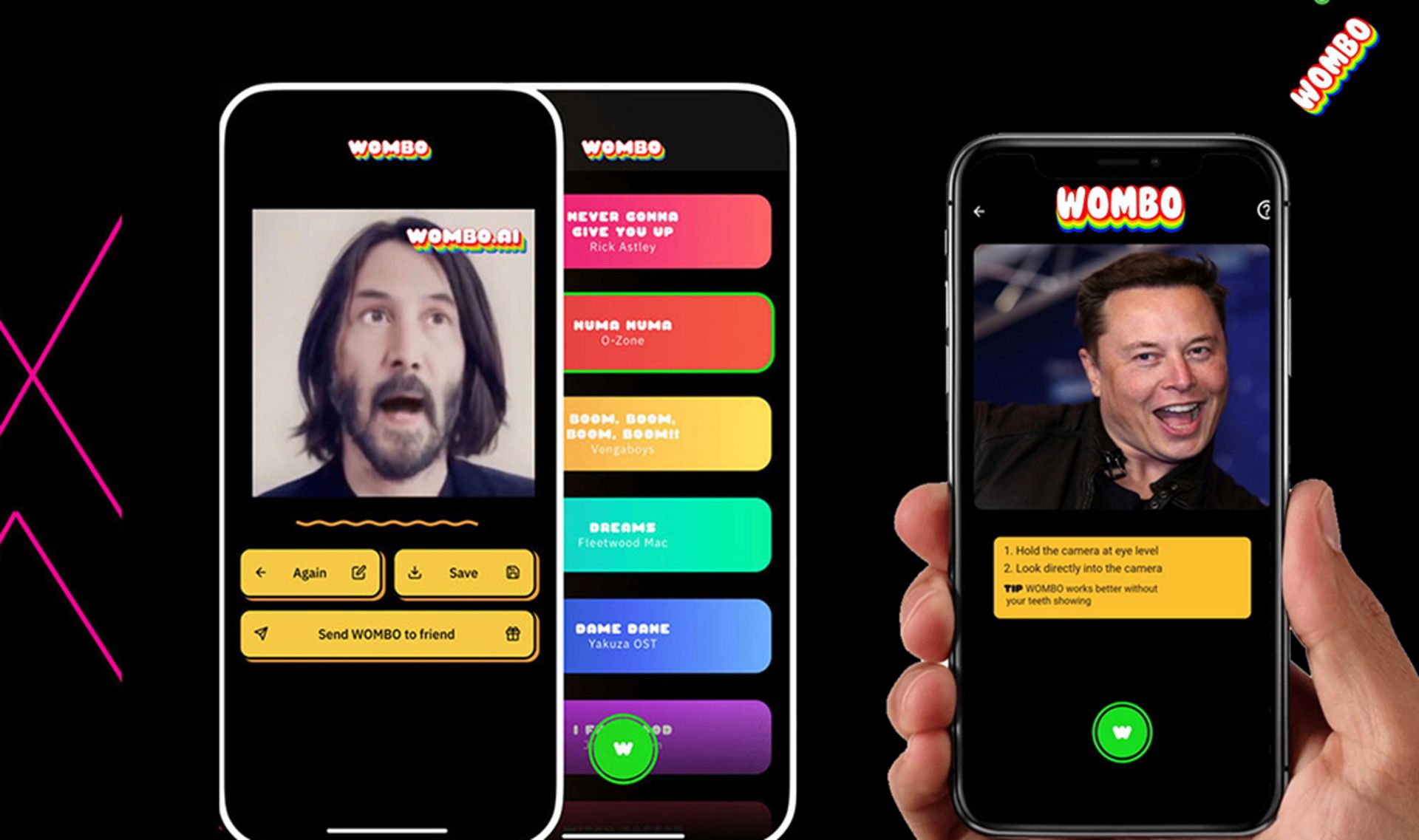

۲- اپليكيشن Wombo

اين يكي را احتمالا ميشناسيد و كليپهايي را كه با آن ايجاد شده، در گوشهوكنار اينترنت ديدهايد. Wombo اپليكيشني براي همگامسازي حركات لب است كه به شما اجازه ميدهد تصوير خود يا اشخاص ديگر را به ويديويي تبديل كنيد كه در آن لبهايتان حركت ميكند، انگار داريد آواز ميخوانيد. اين اپليكيشن، ۱۵ آهنگ پيشفرض ارائه ميدهد كه ميتوانيد با تمام آنها از تصوير موردانديشه متخصصين خود ديپفيك بسازيد.

۳- اپليكيشن Reface

اپليكيشن ساخت ديپفيك Reface كه ابتدا با نام Doublicat شناخته ميشد، به شما امكان ميدهد ميمهاي خندهدار با فرمت گيف درست كنيد. اين اپليكيشن از هوش مصنوعي Reface AI كمك ميگيرد كه درواقع نوعي شبكه مولد رقابتي است. براي استفاده از اين اپ تنها كافي است از خودتان عكس بگيريد و بعد فايل گيف مورد انديشه متخصصينتان را از بين ميليونها گيفي كه در اينترنت موجود است، انتخاب كنيد تا در عرض چند ثانيه، اپليكيشن Reface چهرهي شما را روي گيف قرار ميدهد.

البته در انديشه متخصصين داشته باشيد كه كيفيت گيفهاي ايجاد شده هميشه خوب نيست و به ميزان تطابق چهره با گيف بستگي دارد.

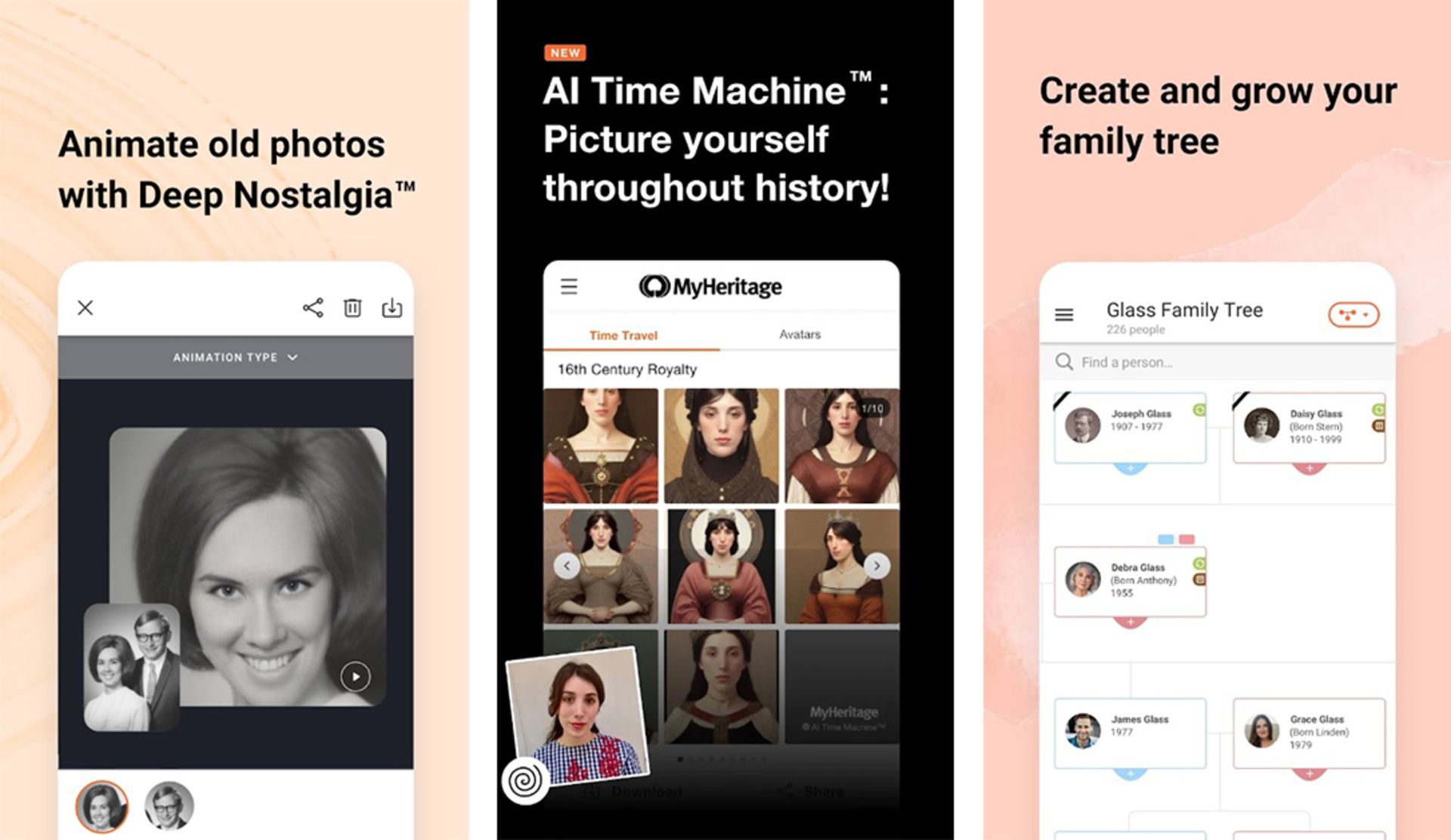

۴- اپليكيشن MyHeritage

يكي ديگر از اپليكيشنهاي ديپفيك كه در شبكههاي اجتماعي محبوبيت زيادي پيدا كرد، MyHeritage نام دارد؛ چراكه به متخصصان امكان ميدهد عكسهاي قديميشان را متحرك كنند. براي استفاده از اين سرويس تنها كافي است عكسي را آپلود كرده و دكمهي Animate را فشار دهيد.

اين اپليكيشن در عرض چند ثانيه، يك نسخهي متحرك از تصوير شما را تحويل ميدهد كه در آن چهره، چشمها و دهان حركت ميكنند؛ درست شبيه عكسهاي جادويي روزنامهي The Daily Prophet در دنياي هري پاتر!

۵- نرمافزار DeepFaceLab

DeepFaceLab نرمافزاري است كه به شما امكان ميدهد در محيط ويندوز، ويديوهاي ديپفيك باكيفيتي بسازيد. اين نرمافزار در درجه اول براي پژوهشگران و دانشجويان بينايي ماشين در انديشه متخصصين گرفته شده است. بااينحال، اگر دوست داريد از ويديوهاي ديپفيك بيشتر سر در بياوريد، ميتوانيد از اين ابزار استفاده كنيد. DeepFaceLab از يادگيري ماشين و تلفيق تصوير انساني براي جايگزين كردن چهرهها در ويديو استفاده ميكند.

از آنجاييكه DeepFaceLab ابزار پيشرفتهاي براي پژوهشگران است، رابط متخصصي پيچيدهاي دارد و براي استفاده از آن بايد كمي مطالعه كنيد. همچنين، براي رندر كردن ويديو، به كامپيوتري با پردازنده گرافيكي مجزاي قدرتمندي نياز داريد. اگر دانشجوي بينايي ماشين هستيد، DeepFaceLab ميتواند ابزار فوقاعلادهاي براي درك ويديوهاي ديپفيك باشد.

جالب است بدانيد شركت انويديا نيز بهتازگي ابزاري مبتني بر هوش مصنوعي معرفي كرده كه از طريق نرمافزار تماس ويديويي و استريم ويديوي Broadcast آن، ميتواند تماس چشمي افراد را بهصورت ديپفيك اصطلاح كند. اين قابليت كه Eye Contact نام دارد و شبيه قابليت Attention Correction فيستايم اپل است كه همراه با iOS 13 در سال ۲۰۱۹ عرضه شد، بهكمك هوش مصنوعي، خط ديد متخصص را مانيتور ميكند و بعد ويديوي در حال پخش را طوري دستكاري ميكند تا به انديشه متخصصين برسد متخصص همواره در حال نگاه كردن به دوربين است.

هدف از توسعهي Eye Contact اين بوده تا فردي كه درحال سخنراني است يا يك لحظه حواسش به چيزي پرت ميشود، اينطور به انديشه متخصصين نرسد كه نگاهش روي افرادي كه در حال تماشاي ويديو هستند، متمركز نيست. حالا اينكه متخصصان از اين قابليت براي بهتر كردن تجربهي سخنراني خود استفاده كنند يا وانمود كنند كه حوصلهشان از شركت در جلسه الكترونيك سر نرفته، به خودشان بستگي دارد.

مثالهاي ويديويي از ديپفيك

احتمالاً اولين آشنايي بسياري از ما با ويدئوهاي ديپفيك، همان سخنراني جعلي باراك اوباما، رئيس جمهور پيشين آمريكا بوده كه از دل پروژهي Synthesizing Obama بيرون آمده است. بااينحال، در اين چند سال، ويديوهاي ديپ فيك ديگري نيز در اينترنت همهگير شدهاند.

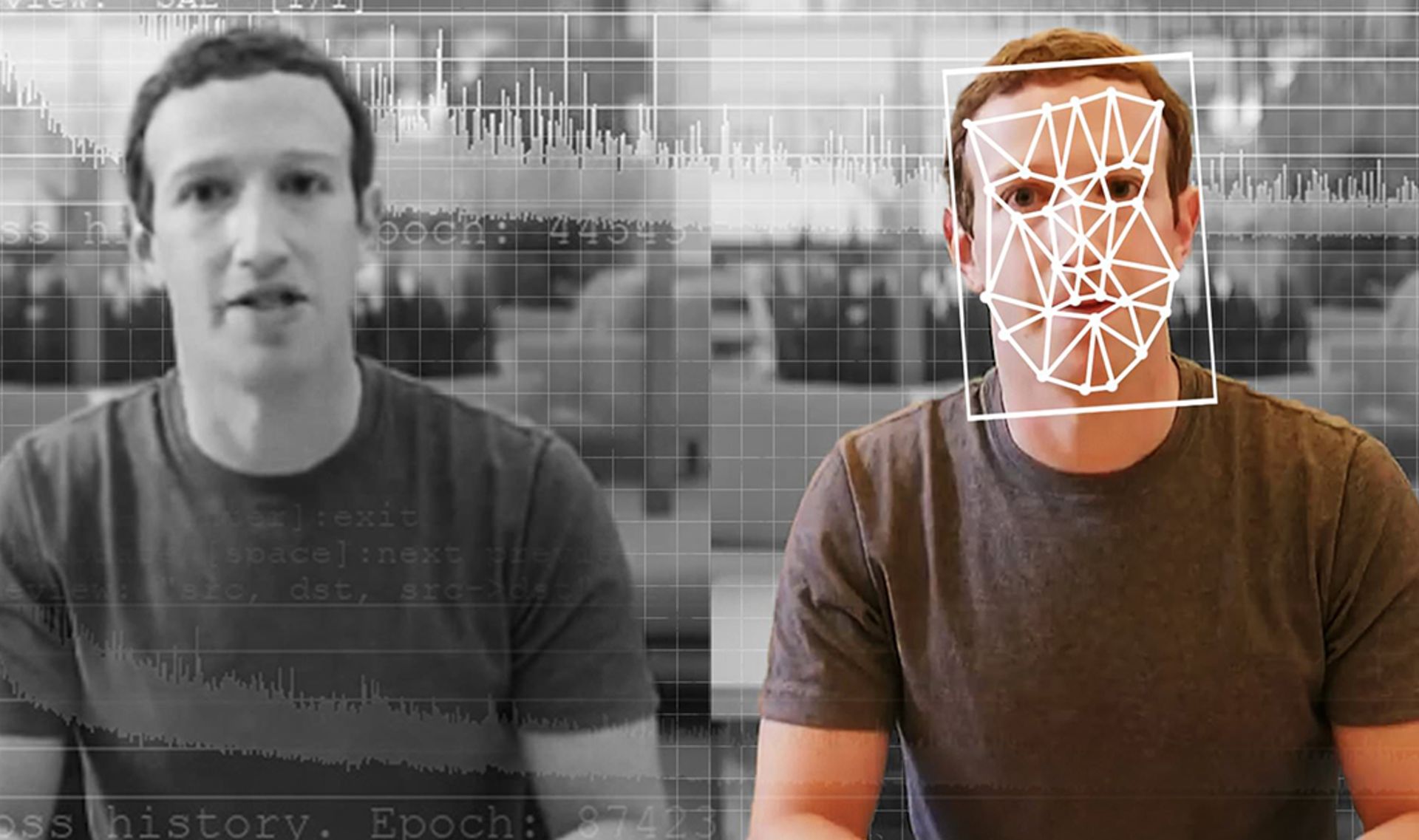

در يك نمونه از اين ويدئوها، مارك زاكربرگ، مديرعامل شركت متا را ميبينيم كه با صدايي رباتگونه، جملهي «هركسيكه دادهها را كنترل ميكند، آينده را كنترل ميكند» را بر زبان ميآورد. در ادامه ميتوانيد سه نمونهي از اين ويدئوها را تماشا كنيد:

در ويديوي بالا، جان اسنو، يكي از شخصيتهاي محوري سريال «بازي تاج و تخت» را ميبينيم كه در صحنهاي از فيلم، بابت تمام اشتباهاتي كه اين سريال در طول فصل هشتم انجام داده، از طرفداران عذرخواهي ميكند. او فيلمنامه فصل ۸ را حاصل كاري ششروزه عنوان ميكند و درآخر از همه ميخواهد تا براي فراموشي اين فصل، فيلمنامهي آن را در آتش بسوزانند. اگرچه اين ويدئو نسبت به ديگر نمونههاي ديپفيك از كيفيت پايينتري برخوردار است؛ اما قطعاً با پيشرفت اين فناوري ميتوان آيندهاي را متصور شد كه هركس طبق علايق خود، ديالوگ موردانديشه متخصصينش را براي صحنههاي مختلف فيلم درانديشه متخصصين بگيرد.

ويدئوي بعدي كه كيفيت بسيار بالاتري دارد، بيل هيدر را در حال تقليد صداي آرنولد شوارتزينگر نشان ميدهد؛ اما نكته مهم درباره اين ويدئو، تغيير چهره ناگهاني وي به چهره آرنولد است. اين اتفاق بهقدري طبيعي اتفاق ميافتد كه گويي چنين رخدادي در دنياي واقعي رخ ميدهد.

يكي ديگر از واقعيترين ويديوهاي جعلي كه به كمك تكنيك ديپفيك ساخته شده است، ويديوي ديپفيك مورگان فريمن است. مطمئنم اگر به شما نگفته بودم ويديوي بالا جعلي است، باور ميكرديد كه خود مورگان فريمن دارد جملهي «من مورگان فريمن نيستم و آنچه ميبينيد، واقعي نيست.» را به زبان ميآورد. اين ويديو اولينبار در كانال يوتيوب Diep Nep منتشر شد و صداگذاري فوقالعادهي آن را شخصي به نام Boet Schouwink انجام داده است.

چگونه ديپ فيك را شناسايي كنيم؟

هر تكنولوژي نوظهور هميشه با دردسرها و نگرانيهاي زيادي همراه است، چراكه انسانها اكثرا ترجيح ميدهند از قوهي تخيل و خلاقيتشان براي رد شدن از مرزها، شكستن قانونها و كلا فعاليتهاي مجرمانه و غيراخلاقي استفاده كنند. بههمينترتيب، دربارهي تكنولوژي ديپفيك نيز اين نگراني وجود دارد كه روزي به ابزار و سلاحي فوقالعاده قدرتمند براي پخش گستردهي اطلاعات نادرست، نفرتپراكني و آزار و اذيت متخصصان در شبكههاي اجتماعي تبديل شود. بهويژه حالا كه ساخت ويديوهاي ديپفيك با يك كليك ساده و در عرض چند ثانيه امكانپذير است.

براي همين، بسيار مهم است بتوانيم ويديوهاي ديپفيك را از ويديوهاي اصلي تشخيص دهيم. فيسبوك كه از زمان همهگير شدن پديدهي ديپفيك، بيشتر از هر پلتفرم ديگري درگير جنبهي تاريك اين تكنولوژي بوده است، با همكاري مايكروسافت، آمازون وب سرويس و ائتلاف Partnership on AI، مسابقهاي با عنوان Deepfake Detection Challenge را در پلتفرم Kaggle گوگل برگزار ميكند. در اين مسابقه، از شركتكنندگان خواسته ميشود تا با الگوريتمهايي كه خودشان توسعه دادند، روي مجموعهي بزرگي شامل ۱۰۰ هزار ويديوي ديپفيك كه توسط فيسبوك ساخته شده، كار كنند و تشخيص دهند كدام ويديو فيك است. در يك دوره از اين مسابقات، بيش از ۲ هزار نفر شركت كردند و بيش از ۳۵ هزار مدل تشخيص ديپفيك معرفي شد.

بهترين مدلي كه در اين مسابقه انتخاب شد، در بيش از ۸۲ درصد موارد ميتوانست بهدرستي ويديوي ديپفيك را تشخيص دهد. اما زماني كه اين مدل روي ويديوهاي تابهحال ديده نشده، تست ميشد، درصد تشخيص آن به ۶۵ كاهش پيدا ميكرد.

دركل، تشخيص ديپفيك بهكمك هوش مصنوعي شبيه موشوگربه بازي است؛ چراكه الگوريتمهاي ساخت ديپفيك ميتوانند خود را با مدل تشخيص ديپفيك يادگيري دهند و ياد بگيرند چطور از الگوريتمهاي تشخيص اين مدل فرار كنند.

شركت اينتل نيز ابزاري بهنام FakeCatcher توسعه داده كه مدعي است ميتواند در لحظه «با مطالعه جريان خون در پيكسلهاي ويديو»، فيكديپ بودن آن را تشخيص دهد!

اما آيا راهي وجود دارد تا متخصصان معمولي مثل ما بتوانند بدون استفاده از الگوريتم، ويديوي واقعي را از ديپفيك تشخيص دهند؟ گروهي از پژوهشگران دانشگاه MIT براي اين كار، وبسايت Detect Fakes را راهاندازي كردهاند تا متخصصان بتوانند قدرتشان را در تشخيص ديپفيك محك بزنند.

بهگفتهي اين پژوهشگران، علائم بسيار جزيي در ويديوهاي ديپفيك وجود دارد كه نشان ميدهد توسط الگوريتمها دستكاري شدهاند. آنها توصيه ميكنند براي تشخيص ديپفيك، به نكات زير توجه كنيم:

- به چهره توجه كنيد. دستكاريهاي حرفهاي ديپفيك معمولا روي تغييرات چهره متمركز هستند.

- به گونهها و پيشاني توجه كنيد. آيا پوست بيشازاندازه صاف يا پرچينوچروك است؟ آيا چروك پوست با پيري چشمها و موها همخواني دارد؟

- به چشمها و ابروها توجه كنيد. آيا سايهها در نقاطي ظاهر ميشوند كه انتظار داريد؟

- به عينك توجه كنيد. آيا بازتاب نور از آن مشخص است؟ آيا نور بازتابشده بيش از حد زياد است؟ آيا زاويه بازتاب نور با حركت فرد، تغيير ميكند؟ ديپفيك گاهي نميتواند بهدرستي نور طبيعي را نمايش دهد.

- به موهاي صورت يا نبود آنها توجه كنيد. آيا موي صورت واقعي بهانديشه متخصصين ميرسد؟ ديپفيك گاهي سبيل، خط ريش يا خود ريش را حذف يا اضافه ميكند. گاهي نيز نميتواند تغييرات موهاي صورت را بهطور طبيعي نشان دهد.

- به خالهاي صورت توجه كنيد. آيا واقعي بهانديشه متخصصين ميرسند؟

- به پلك زدنها توجه كنيد. آيا فرد به اندازه كافي يا بيش از حد پلك ميزند؟

- به حركات لب توجه كنيد. برخي از ديپفيكها از نوع همگامسازي حركات لب هستند. آيا حركات لب طبيعي بهانديشه متخصصين ميرسد؟

اين هشت سوال براي كمك به تشخيص ويديوهاي ديپفيك در انديشه متخصصين گرفته شدهاند. تشخيص ديپفيكهاي باكيفيت آسان نيست، اما با تمرين ميتوان به دركي نسبي براي تشخيص ويديوي واقعي از جعلي دست پيدا كرد. شما ميتوانيد براي تمرين از كلكسيون كليپهاي ديپفيك Detect Fakes استفاده كنيد.

هم انديشي ها