با تكامل فناوري ديپ فيك، تشخيص واقعي يا تقلبي بودن ويدئو كار دشواري شده است. خوشبختانه گروههاي مختلف شبكههاي عصبي پيچيدهاي براي شناسايي چهرههاي جعلي توسعه دادهاند؛ اما دانشمندان علوم رايانهاي هفته گذشته راهي يافتهاند كه توسط آن ميتوان حتي قويترين سيستمهاي تشخيص صحت ويدئو را فريب داد.

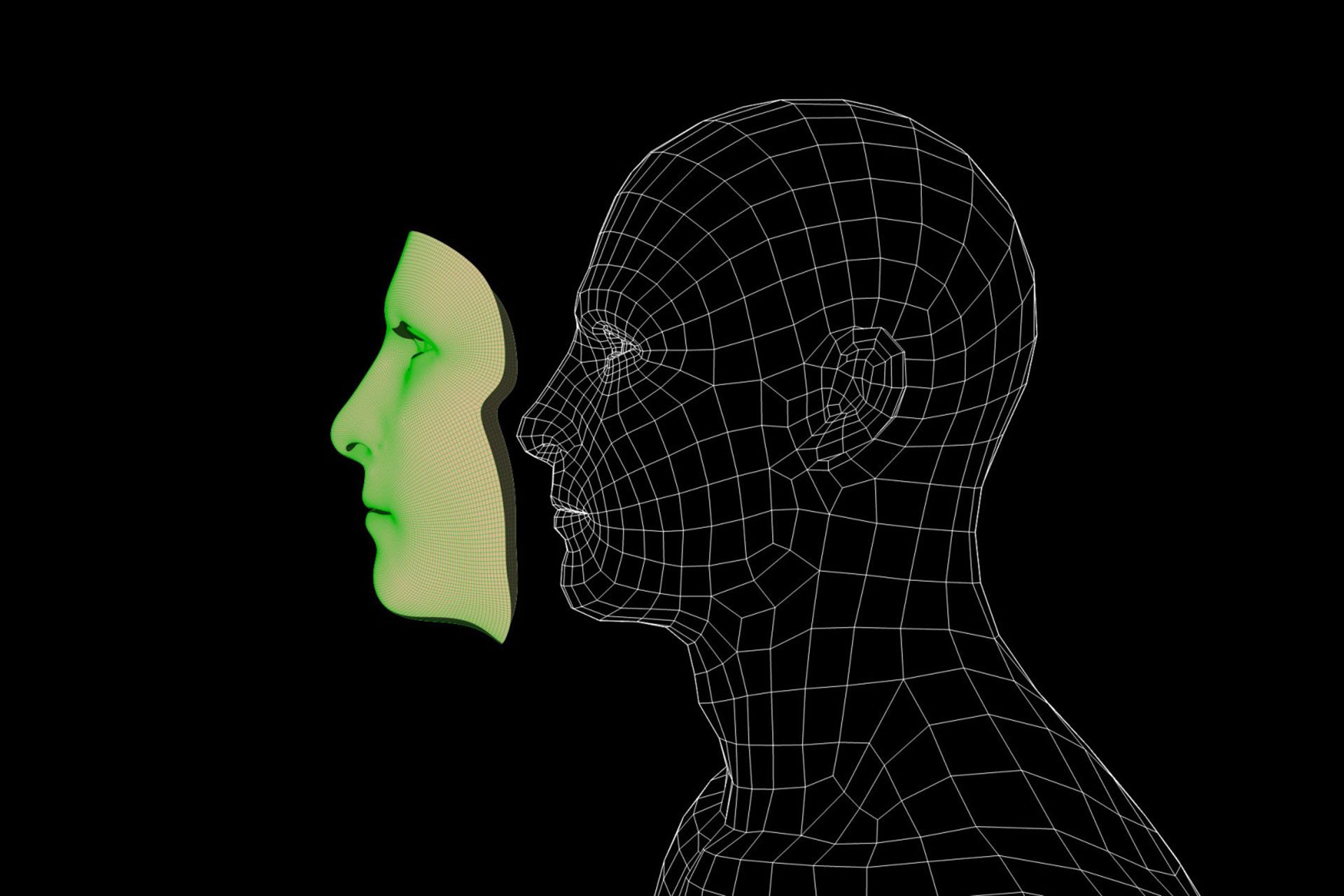

براساس گزارش Tech Spot، محققان دانشگاه كاليفرنيا، سن ديگو، تكنيكي ايجاد كردهاند كه ميتواند الگوريتمهاي يادگيريديده براي كشف فيلمهاي ديپ فيك را فريب بدهد. با استفاده از يك روش دومرحلهاي، ميتوان جعلي بودن ويدئوي ديپ فيك قابل تشخيص را با اضافه كردن لايههايي خاص به هر فريم، كاملا پنهان كرد.

لايههاي اضافهشده در واقع تصاوير دستكاريشدهاي هستند كه باعث بروز بينظمي در سيستم يادگيري ماشيني ميشوند و به همين دليل، صحت ويدئو به اشتباه تأييد ميشود. يك مثال قابل درك براي اين روش، استفاده از چسب برق و استيكر براي پوشاندن بخشي از علائم راهنمايي و رانندگي است كه موجب ميشود خودروهاي خودران فريب بخورند و تابلوها را اشتباه تشخيص بدهند.

البته در اين روش، برخلاف تابلوهاي دستكاريشده، فيلم خدشهدار نميشود و نتيجه نهايي تغييري در ظاهر تصوير ايجاد نميكند. اين ويژگي از آن جهت مهم است كه ويدئوهاي ديپ فيك قرار است انسانها و دستگاهها را فريب بدهند و اگر با چشم انسان جعلي بودن آنها قابل تشخيص باشد، ديگر نيازي به استفاده از سيستم خاص براي مطالعه كردن اين مسئله نيست. محققان در اين زمينه دو نوع حمله را تشخيص دادهاند كه يكي «جعبه سفيد/ White Box» و ديگري «جعبه سياه/ Black Box» نام دارد. هر دوي اين روشها به قدري پيشرفت كردهاند كه ميتوانند حتي پيشرفتهترين سيستمهاي تشخيص را فريب بدهند.

از چند سال پيش كه ويديوهاي مختلفي با تكنيكهاي ديپ فيك ساخته و در فضاي مجازي منتشر شد، مباحثه و جدال زيادي سر اين فناوري به وجود آمده است. ابتدا بسياري از سلبريتيها به دليل شباهت بسيار بالاي مدلهاي تقلبي در ويدئوهاي ديپ فيك به آنان خشمگين شدند. اما همانطور كه اين فناوري پيشرفت كرد و ويدئوهاي جديدتري منتشر شدند، مشخص شد كه ديپ فيك ميتواند براي تبليغات يا اهداف پليدتري مورد استفاده قرار بگيرد.

دانشگاهها اولين مراكزي بودند كه الگوريتمهايي براي شناسايي ويدئوهاي تقلبي ايجاد كردند و به دنبال آن، وزارت دفاع ايالات متحده آمريكا بهسرعت آن را پيگيري كرد. چندين غول فناوري از جمله توييتر، فيسبوك و مايكروسافت نيز در حال توسعه روشهايي براي شناسايي ويدئوهاي جعلي هستند. محققان ميگويند بهترين روش براي مبارزه با اين تكنيك، يادگيري سيستمهاي هوش مصنوعي كه براي اينكار طراحي شدهاند.

انديشه متخصصين شما متخصصان اخبار تخصصي، علمي، تكنولوژيكي، فناوري مرجع متخصصين ايران دربارهي اين فناوري و روشهاي مقابله با آن چيست؟ آيا ميتوان روزي همهي ويدئوهاي تقلبي را تشخيص داد؟

هم انديشي ها