OpenAI نسخه كامل هوش مصنوعي توليدكنندهي متن GPT-2 را منتشر كرد

لابراتور تحقيقاتي OpenAI نسخهي كامل سيستم هوش مصنوعي توليدكنندهي متن بهنام GPT-2 را منتشر كرده است. اين موفقيت در حالي حاصل شده است كه متخصص كارشناسان هشدار دادند اين سيستم هوش مصنوعي ميتواند براي اهداف مخرب استفاده شود. GPT-2 مخفف واژههاي Generative Pretrained Transformer است. حرف G مخفف واژهي Generative بهمعناي «توليدكننده يا زايا» و حرف P مخفف واژهي Pretrained بهمعناي «پيشيادگيري دادهشده» و حرف T مخفف واژهي Transformer بهمعناي «مبدل يا ترنسفورمر» است.

در فوريهي سال جاري، مؤسسهي تحقيقاتي OpenAI فناوري خارقالعادهي GPT-2 را رونمايي كرد كه ميتوانست با كمترين دخالت انساني، متوني منسجم شامل چندين پاراگراف را از خود بنويسد. حتي در توضيحات گاردين اينگونه آمده بود كه اين سيستم هوش مصنوعي متون چندكلمهاي تا يكصفحهاي را بهعنوان ورودي دريافت ميكند و ميتواند چندين جمله را باتوجهبه پيشبينيهاي خود درادامهي آن بنويسد.

بااينهمه، OpenAI بهدليل نگرانيهاي ناشي از سوءاستفادههاي احتمالي ازقبيل انتشار اخبار جعلي و هرزنامهها و اطلاعات نادرست، نسخهي كامل اين فناوري را منتشر نكرد. از آن زمان نسخههاي كوچكتر و كمتري از GPT-2 منتشر شده است و پذيرش آنها مطالعه شده است. برخي ديگر نيز GPT-2 را نيز بارها آزمايش كردهاند. درنهايت، لابراتور تحقيقاتي OpenAI اين هفته در پستي در وبلاگ خود نوشت:

هيچ مدرك محكمي دربارهي سوءاستفاده و مخرببودن GPT-2 وجود ندارد؛ ازاينرو، نسخهي كامل اين فناوري منتشر شده است.

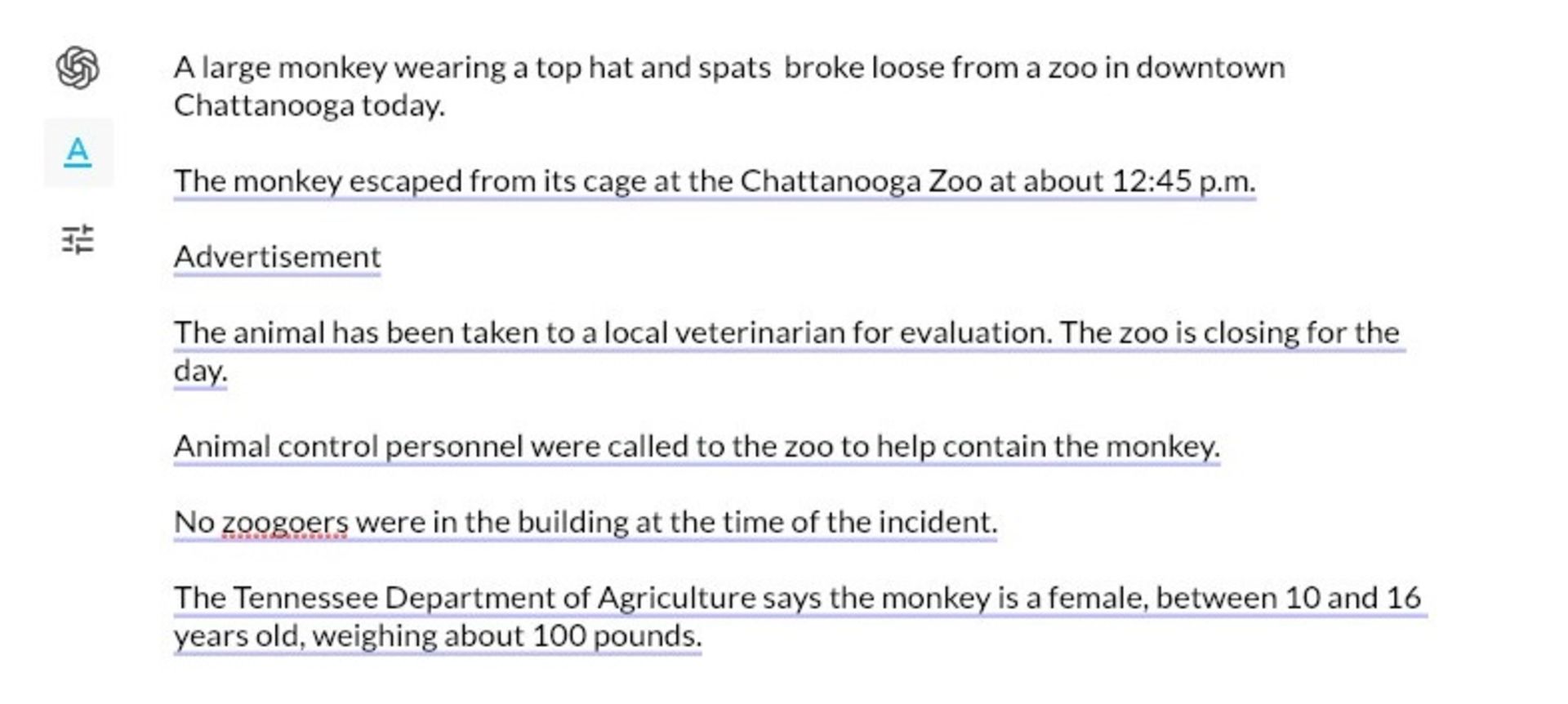

نمونهي توليد متني از الگوريتم مدلسازي زبان OpenAI GPT-2

هوش مصنوعي زباني GPT-2 بخشي از نسل جديدي از سيستمهاي توليد متن است كه متخصصان را تحتتأثير توانايي خود براي توليد متن منسجم با دراختيارداشتن حداقل دادهها قرار داده است. بهطور خاص، OpenAI هوش مصنوعي GPT-2 را برپايهي دادههاي متني دريافتشده يادگيري داده است كه متخصصان و نويسندگان ارسال كردهاند. تمام دادههاي گرفتهشده از لينكهاي وب و متن بودند؛ بههميندليل، به ديتاست بهدستآمده WebText گفته شد. بيش از ۴۰ گيگابايت دادهي اينترنتي بههمراه تقريبا ۱/۵ ميليارد پارامتر از ساختارهاي متني براي يادگيري GPT-2 بهكار گرفته شده است. بهعنوان مثال، ميتوانيد تنها با دادن عنواني جعلي، از GPT-2 بخواهيد مطلبي دربارهي آن بنويسد يا فقط با ارائهي مصرعي از يك شعر، كل شعر را از GPT-2 تحويل بگيريد.

پيبردن به عملكرد هوش مصنوعي زباني GPT-2 از روي خروجي دادههاي آن بسيار دشوار است؛ اما اين مدل زباني اغلب نوشتههاي پررمزورازي توليد ميكند كه حتي ميتوان نشانههايي از شعور يا هوش را در آن رديابي كرد. اين بدان معنا نيست كه GPT-2 نيز مجهز به همان قدرت و ويژگي است كه ما آن را بهعنوان شناخت ميشناسيم. اگر با اين سيستم به اندازهي كافي كار كنيد، محدوديتهاي آن نيز برايتان بهخوبي مشخص خواهد شد. يكي از ضعفهاي آن در حفظ انسجام متون بلند است. براي نمونه، استفاده از نامها و صفتهاي شخصيتها بهطور مداوم در داستان يا اصرار بر نوشتن دربارهي موضوع واحد در مقالهاي خبري.

بهترين روش براي تخمين قابليتهاي GPT-2 اين است كه خودتان آن را امتحان كنيد. براي دسترسي به اين سيستم، ميتوانيد به نسخهي وب در TalkToTransformer.com مراجعه كنيد و پيام و سوال خودتان را مطرح كنيد. واژهي «ترنسفورمر» مؤلفهاي از معماري يادگيري ماشين است كه براي ايجاد GPT-2 و ديگر بخشهاي آن استفاده ميشود. گفتني است ترنسفورمرها معماري بينظيري از شبكههاي عصبي هستند.

جدا از قابليتهاي خام GPT-2، انتشار اين مدل بهعنوان بخشي از مباحثه دربارهي مسئوليتپذيري پژوهشگران هوش مصنوعي براي كاهش آسيبهاي ناشي از كار درخورتوجه است. متخصص كارشناسان پيشتر نيز خاطرنشان كرده بودند دسترسي آسان به تمام ابزارهاي اين هوش مصنوعي ميتواند به فعال كردن بخشهاي مخربي منجر شود. براي نمونه، پويايياي كه در اين فناوري وجود دارد، ميتواند با مونتاژ تصوير چهرهي فردي روي چهرهي فردي ديگر، به توليد ويدئوهاي جعلي يا ديپفيك (Deepfake) منجر شود. بنابراين، بهدليل وجود چنين نگرانيهايي، OpenAI انتشار مدل خود را محدود كرده است.

بيش از ۴۰ گيگابايت دادهي اينترنتي بههمراه تقريبا ۱/۵ ميليارد پارامتر از ساختارهاي متني براي يادگيري GPT-2 بهكار گرفته شده است

شايان ذكر است همه از اين رويكرد لابراتوار OpenAI استقبال نكردهاند و بسياري از متخصص كارشناسان با انتقاد از چنين تصميمي، بيان كردند با انجام اين كار دامنهي تحقيقاتي كساني محدود ميشود كه اين مدل را كاهش ميدهند و توقعهاي غيرضروري دربارهي خطرهاي هوش مصنوعي ايجاد خواهد كرد. دليپ رائو، پژوهشگر اين پروژه به خبرگزاري The Verge گفت:

كلمات بسيار خطرناك هستند؛ بهخصوص زمانيكه بدون هيچ تفكري و تنها با آزمايش توليد خواهند شد. فكر نميكنم [OpenAI] وقت كافي را براي اثبات خطرناك بودن اين سيستم صرف كند.

OpenAI در بيانيهاي كه اين هفته دربارهي مدل كامل GPT-2 منتشر كرده بود، خاطرنشان كرد GPT-2 اين سيستم ميتواند به توليد «تبليغات مصنوعي» براي موقعيتهاي ايدئولوژيك افراطي كمك كند؛ ازاينرو، ممكن است با استناد به تحقيقات شخص ثالث از آن سوءاستفاده شود. اگرچه OpenAI بر ترس و نگراني خود اعتراف كرد و گفت ممكن است از اين سيستم براي بيرونكشيدن حجم زياد اسپم منسجم يا بسياري از سيستمهاي اطلاعاتي الكترونيك عملينشده مانند رسانههاي اجتماعي استفاده شود.

همچنين، اين لابراتوار خاطرنشان كرد پژوهشگران خود OpenAI سيستمهاي خودكاري ايجاد كردند كه ميتواند خروجي GPT-2 را با دقت ۹۵ درصدي تشخيص دهند؛ اما اين رقم براي «تشخيص سيستم خودكفا» كافي نيست؛ يعني هر سيستمي كه براي شناسايي خودكار متن جعلي موردنياز باشد، بهتنهايي كافي نيست و درنهايت، براي تشخيص نهايي به داوري انساني نيازمند است. گرچه انجام چنين كارهايي اغلب عجيب نيست كه متكي به تشخيص و شناسايي نهايي انسان در اين سيستم باشد؛ بهويژه براي تشخيص جعلي بودن يا نبودن تصاوير و ويدئوها.

OpenAI قصد دارد فعلا نظارهگر نحوهي استفادهي جامعه و عموم مردم از GPT-2 باشد تا در آينده، بهتر بتواند سياستهاي خود را دربارهي انتشار مسئولبودن تحقيقات هوش مصنوعي تدوين كند.

هم انديشي ها