قابليت زيرنويس خودكار اندرويد 10 چگونه كار ميكند؟

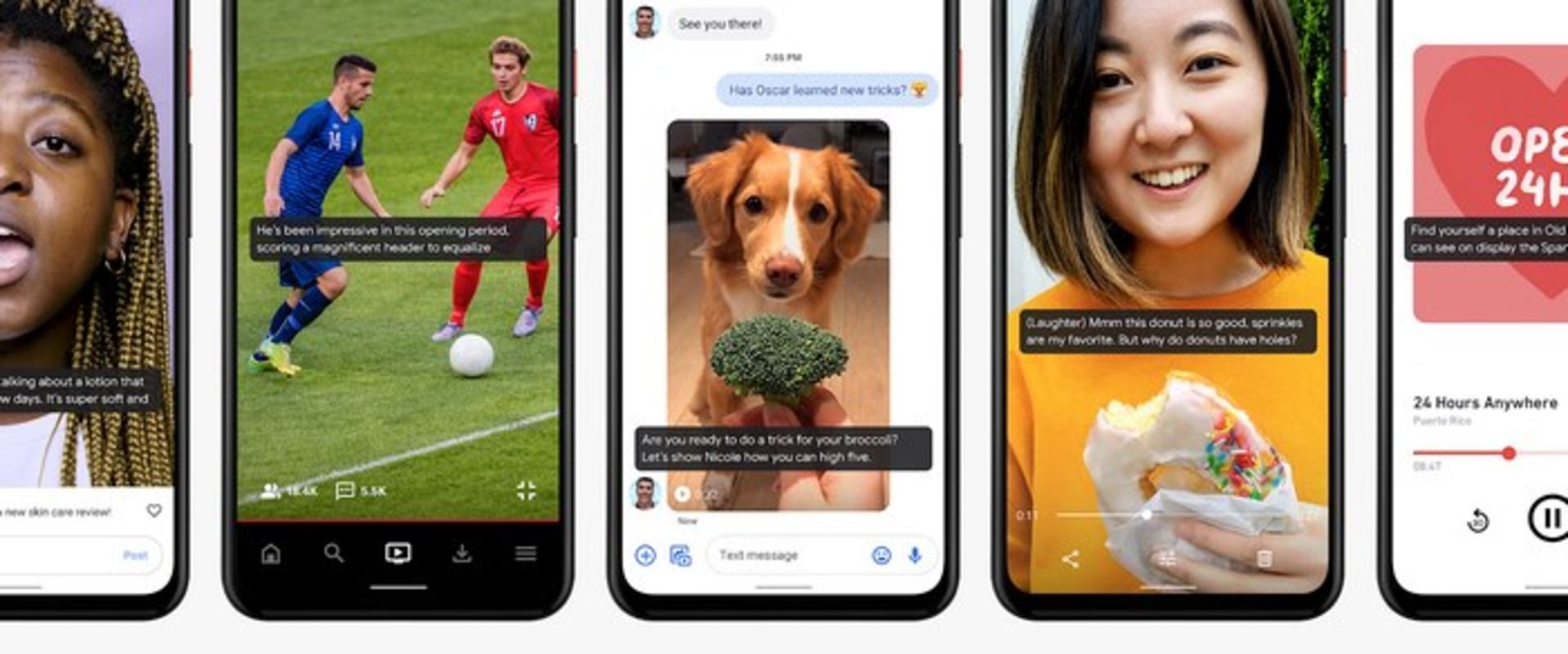

وجود زيرنويس در محتواي صوتي براي ناشنوايان و كم شنوايان ضروري است، اما براي عموم مردم نيز وجود آن عاري از بهره نيست. تماشاي ويديوهاي بيصدا در قطار، جلسات، هنگامي كه كودكان خوابيدهاند و مواردي از اين قبيل معمولا امر رايجي است و همچنين مطالعات نشان ميدهند كه وجود زيرنويس، مدت زماني را كه متخصص صرف تماشاي فيلم ميكند، حدود ۴۰ درصد افزايش ميدهد. در حال حاضر قابليت همراهي از زيرنويس بهصورت يكپارچه در ميانِ برنامهها و حتي در درون آنها وجود ندارد. به همين دليل در حجم قابل توجهي از محتواي صوتي از جمله وبلاگهاي پخش ويديوهاي زنده، پادكست ها، ويديوهاي محلي، پيامهاي صوتي و رسانههاي اجتماعي، امكان دسترسي به زيرنويس وجود ندارد.

Live Caption، يكي از نوينترين و جالبترين ويژگيهاي سيستمعامل اندرويد است كه به كمك شاخهاي وسيع و پر متخصصد از هوش مصنوعي با نام يادگيريِ ماشين، جهت توليد زيرنويس براي انواع ويديوهاي تحت وب و محلي در موبايلهاي هوشمند مورد استفاده قرار ميگيرد. توليد زيرنويس، بهصورت آني و با استفاده از اطلاعات محليِ خود موبايل، بدون نياز به منابع الكترونيك صورت ميگيرد كه نتيجهي آن حفظ بيشتر حريم خصوصي و كاهش زمان ايجاد زيرنويس خواهد بود. گوگل در وبلاگ رسميِ اين شركت پستي را منتشر كرده كه جزئيات دقيقي از نحوهي عملكرد اين ويژگيِ عالي را نشان ميدهد. عملكرد ياد شده با استفاده از مدلهاي ژرف يادگيري ماشين در سه مقطع مختلف در اين فرايند ايجاد ميشود.

در وهلهي نخست مدلي بهصورت RNN-T، يا همان هدايت دنبالهي شبكه عصبي بازگشتي براي تشخيص گفتار وجود دارد. RNN، بهمعنيِ شبكهي عصبي بازگشتي يا مكرر، كلاسي از شبكههاي عصبي مصنوعي است كه در آن اتصالات بين، گرههايي از يك گراف جهتدار در امتداد يك دنبالهي زماني هستند و اين امر سبب ميشود تا الگوريتم بتواند موقتا رفتار پويايي را به نمايش بگذارد. برخلاف شبكههاي عصبي رو به جلو، شبكههاي عصبي مكرر ميتوانند از وضعيت دروني خود براي پردازش دنبالهي وروديها استفاده كنند كه اين ويژگي آنها را براي مواردي نظير تشخيص صوت، يا تشخيص دستنوشتههاي غيربخشبندي شدهي متصل مناسب ميكند.

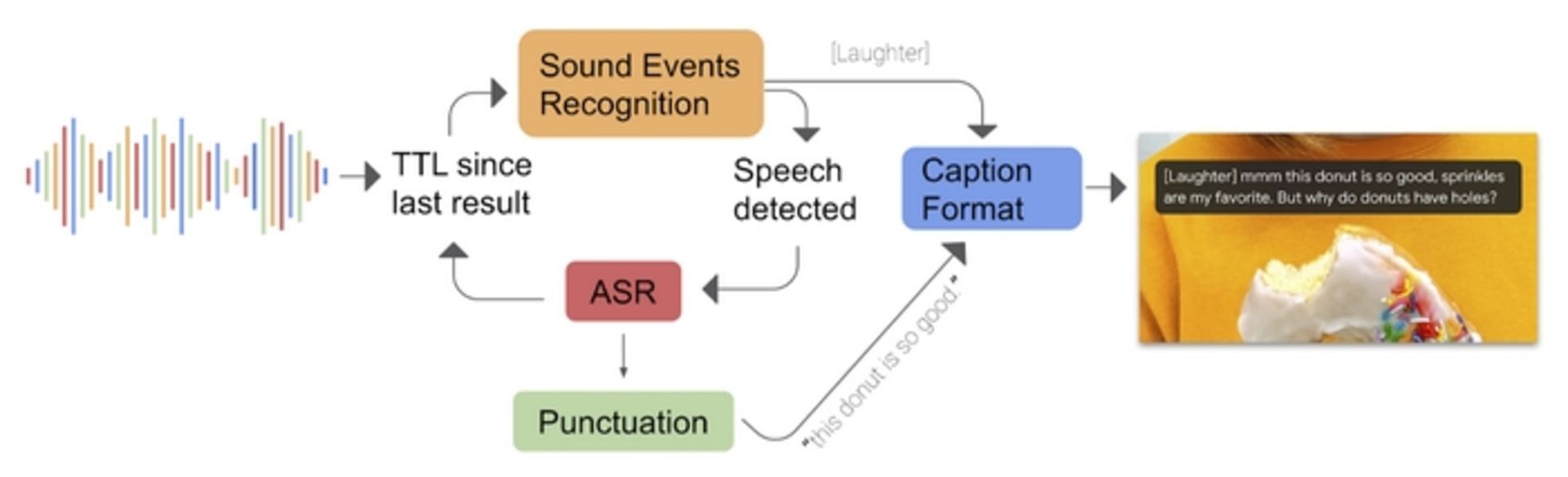

براي انجام پيشبينيهاي نگارشي نيز گوگل از شبكهي عصبي مكرر مبتني بر متن استفاده ميكند. سومين استفاده از مدلهاي يادگيري ماشين شامل يك CNN، يا همان شبكهي عصبيِ پيچشي براي تحليل رويدادهاي صوتي نظير آواز پرندگان، كف زدن افراد و موسيقي است. شبكههاي عصبي پيچشي يا همگشتي ردهاي از شبكههاي عصبي مصنوعي ژرف هستند كه معمولاً براي انجام تحليلهاي تصويري يا گفتاري در يادگيري ماشين استفاده ميشوند. گوگل چنين عنوان كرد كه اين مدل از يادگيريِ ماشين، برگرفته شده از تلاش آنها در جهت ارتقاء نرمافزار accessibility Live Transcribe است. نرمافزار يادشده در سيستمعامل اندرويد به متخصصان اجازهي تبديل گفتار به متن را ميدهد. در نهايت Live Caption، در جهت ايجاد يك زيرنويس واحد، سيگنال دريافتي از سه مدل يادگيريِ ماشين شامل: RNN-T ،RNN و CNN را با يكديگر ادغام ميكند و زيرنويس بهصورت بيوقفه و درنتيجهي جريان صدا نمايش داده ميشود.

گوگل ميگويد اقدامات بسياري براي كاهش توان مصرفي و همچنين بر طرف كردن نيازهاي عملكرديِ Live Caption انجام شده است. براي اولينبار، موتور تشخيص خودكار صدا «ASR»، فقط در هنگام شناساييِ گفتار اجرا ميشود و در پسزمينه غيرفعال خواهد بود. گوگل در وبلاگ خود مسئله را اينگونه تشريح ميكند:

بهعنوان مثال زمانيكه صوت دريافتي بهعنوان موسيقي تشخيص دادهشود و جريان صدا عاري از گفتار باشد، برچسب MUSIC در صفحهنمايش داده شده و موتور تشخيص خودكار صدا بارگذاري نميشود. ASR تنها زماني در حافظه بارگذاري ميشود كه گفتار مجددا در جريان صدا به وجود آيد.

گوگل همچنين از تكنيكهاي هوش مصنوعي مانند هرس اتصال عصبي (neural connection pruning) كه به وسيلهي كاهش اندازهي مدل گفتار انجام ميگيرد نيز استفاده كرده و فرايند را بهصورت كلي بهينهسازي كرده است. به همين دليل توان مصرفي در حدود ۵۰ درصد كاهش مييابد كه همين امر سبب اجراي مداوم Live Caption ميشود. با وجود تماميِ بهينهسازيها در مصرف انرژي، اين ويژگي در بيشتر حالات از جمله تشخيص جريانهاي كوتاه صدا و مكالمات تلفني با پهناي باند كمِ دامنهي صوتي و نيز در هنگام وجود سروصدا در پسزمينهي محتواي صوتي، از عملكرد خوبي برخوردار است.

گوگل تشريح ميكند كه مدل نگارشيِ مبتني بر متن، در جهت اجراي مداوم و بهصورت محلي روي موبايلِ هوشمند، به يك معماريِ معادل كوچكتر از فضاي ابري مجهز شده و سپس به كمك قابليت TensorFlow Lite، براي كار روي سختافزار بهينه شده است. به دليل شكل گيريِ زيرنويس، نتايج تشخيص گفتار چندين بار در هر ثانيه بهروزرساني ميشوند و به منظور كاهش نياز به منابع، پيشبينيهاي نگارشي بر دنبالهي متن، از تجزيه و تحليل آخرين جملهي شناسايي شده از گفتار صورت ميگيرد.

هماكنون Live Caption، در موبايلهاي هوشمند گوگل پيكسل 4 در دسترس قرار دارد و گوگل اعلام كرده است كه اين ويژگي بهزودي براي پيكسلهاي سري 3 و ساير دستگاهها نيز منتشر خواهد شد. اين شركت در تلاش است تا Live Caption را در ساير زبانها نيز متخصصدي كند و ويژگي مذكور را براي همراهي از محتواي داراي قابليت multi-speaker، يا همان پخشكنندهي چندگانهي صدا ارتقا دهد.

هم انديشي ها